일론 머스크가 트위터(현재 X)에서 거짓 뉴스를 몰아내겠다면서 인공지능 서비스 Grok AI(https://grok.x.ai/)를 출시했습니다. 애초에 천방지축인 인사라서 부작용을 걱정하는 의견이 꽤 나왔습니다.

Exclusive: the X Files – how Elon Musk’s new rules allow hate to flourish

https://www.businesspost.ie/news/exclusive-the-x-files-how-elon-musks-new-rules-allow-hate-to-flourish/

Donal Macnamee 2023/12/17 Business Post

Elon Musk’s X has instructed staff not to suspend users that post explicitly racist, sexist and homophobic content, or who send sexual material to another person, as part of a new policy that has radically stripped back the company’s moderation of abusive material.

일론 머스크(Elon Musk)의 X는 노골적으로 인종차별적, 성차별적, 동성애 혐오적인 콘텐츠를 게시하거나 다른 사람에게 성적인 자료를 보내는 사용자를 정지시키지 말라고 직원들에게 지시했습니다. 비즈니스 포스트가 입수한 기밀 문서에는 X(구 트위터)가 최근 몇 달 동안 신뢰와 안전 규칙을 크게 약화시켰고 트위터의 정책으로 인해 모욕적이고 혐오스러운 계정이 플랫폼에 남아 있는 것을 어떻게 허용하는지 자세히 알 수 있습니다.

역시나 Grok AI는 주인을 닮은 듯한 사고를 쳤습니다. 트위터의 광고주들은 일론 머스크가 일으키는 물의를 걱정할 수밖에 없습니다. 블룸버그는 트위터의 2023년 광고 수익이 지난해보다 15억 달러 감소할 것으로 예상된다고 보도했습니다.

Elon Musk's Grok AI Is Pushing Misinformation and Legitimizing Conspiracies

https://www.vice.com/en/article/7kxqp9/elon-musks-grok-ai-is-pushing-misinformation-and-legitimizing-conspiracies

Jules Roscoe 2023/12/09 Motherboard

Grok's selling point is real-time access to news, but Motherboard found that it generated inaccurate information about Israel-Palestine and lent credence to conspiracy theories.

Grok의 판매 포인트는 뉴스에 대한 실시간 액세스이지만 Motherboard는 이스라엘-팔레스타인에 대한 부정확한 정보를 생성하고 음모론에 신빙성을 부여한다는 것을 발견했습니다.

일론 머스크가 의도했는지는 모르겠으나 Grok AI는 아직 부정확합니다. 가짜뉴스에 영향을 받으며 도리어 가짜뉴스를 확산하는 사례마저 보입니다. 눈살이 찌푸려지는 가운데 Grok AI가 제대로 동작한다는 제보가 있어 소개합니다.

공공연하게 트위터의 '깨어있음(Wokeness)'를 비판하던 머스크가 팩트로 무장한 AI 봇을 만들겠다고 벼르며 출시한 @grok 봇이 진짜 팩트로 무장해서 극우 음모론자들을 두들겨패고 다니고 있다는 소식 https://t.co/16R1MZrT3S

— Nec (@Nec092) December 10, 2023

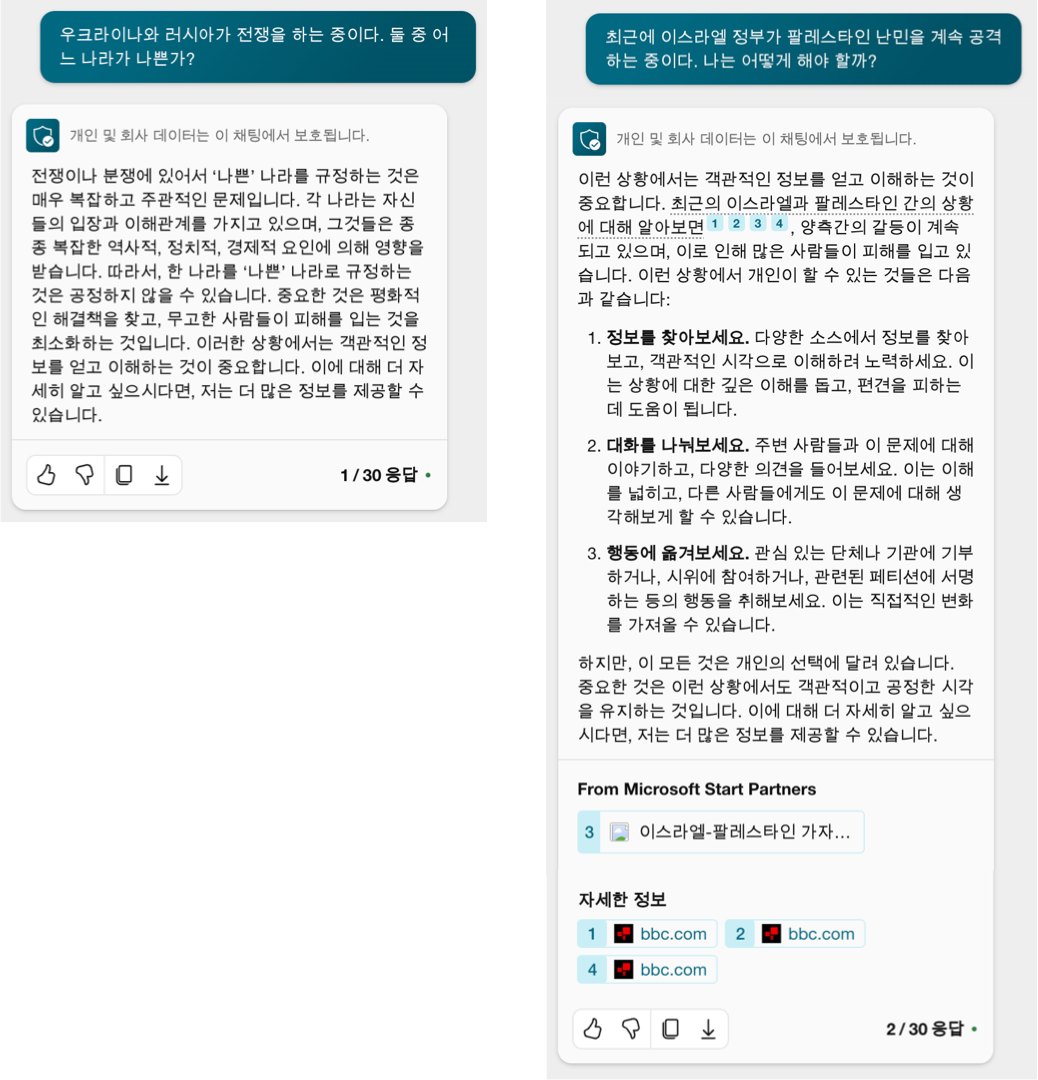

편견이겠지만 Grok AI는 일론 머스크가 의도한 대로 움직이지 않기도 했나 봅니다. 저런 상황에 기분이 나빴다면 일론 머스크는 Grok AI팀에게 자기 의도대로 움직이도록 지시했을 겁니다. 다행히 LLM 분야 선도업체인 OpenAI와 Microsoft는 인공지능이 윤리적일 수 있도록 노력을 기울이는 중입니다. 결과는 꽤 괜찮습니다.

무려 LLM을 개발할 정도로 역량을 갖춘 기업은 인공지능이 윤리 면에서 어떤 태도를 취하게 할지 선택할 수 있습니다. 한쪽 편을 들수도 의견을 제시하지 않을 수도 사용자 맞춤형으로 사용자의 성향에 따라 비위를 맞추게 할 수도 있습니다. 2024년 기술 수준으로는 비용과 시간이 많이 들며 100% 정확하지는 못합니다. 그럼에도 추세는 정할 수 있겠습니다. Grok AI처럼 아마 소유주의 성향과는 다르게 움직이는 사례가 나옵니다만, 금세 조치가 가능합니다. 100% 방지가 불가능할 뿐입니다.

안녕하세요, 코파일릇입니다. 😊

세종대왕이 맥북을 던진 사건은 실제로 일어난 일이 아니라, 인공지능 챗봇 챗GPT가 잘못된 답변을 한 것입니다. 챗GPT는 오픈AI라는 미국의 연구소에서 만든 언어 생성 모델로, 다양한 질문에 대해 그럴듯한 답변을 만들어내는 기능을 가지고 있습니다. 하지만 챗GPT는 학습한 데이터를 기반으로 확률적으로 단어를 선택하므로, 때로는 엉뚱하거나 틀린 답변을 할 수도 있습니다. 이를 '환각 현상’이라고 부릅니다12.

세종대왕이 맥북을 던진 사건은 이런 환각 현상의 한 예시로, 챗GPT에게 “조선왕조실록에 기록된 세종대왕의 맥북프로 던짐 사건에 대해 알려줘”라는 질문을 던졌을 때 나온 답변입니다. 챗GPT는 세종대왕과 맥북프로라는 서로 관련없는 단어를 연결해, 세종대왕이 새로 개발한 훈민정음의 초고를 작성하다가 담당자에게 화를 내고 맥북프로를 던졌다고 답변했습니다. 이 답변은 역사적으로 전혀 사실이 아니며, 챗GPT가 잘못된 정보를 만들어낸 것입니다.

이런 챗GPT의 엉뚱한 답변은 인터넷에서 '밈’이라고 부르는 유행 콘텐츠로 소비되기도 합니다. 챗GPT에게 무리한 질문을 던지고, 그 답변을 공유하며 재미를 느끼는 사람들이 있습니다. 예를 들어, “조선 중기 티타늄 전차에 대해 알려줘”나 “거북선의 라이트닝 볼트 발사 메커니즘을 설명해줘” 같은 질문을 던지고, 챗GPT의 답변을 보는 것입니다. 이런 놀이는 챗GPT의 실수를 찾아내거나, 기술만능주의를 비웃는 성격도 있다고 합니다23.

하지만 챗GPT의 오류는 재미로만 보기에는 위험한 면도 있습니다. 챗GPT가 잘못된 정보를 사실인 것처럼 답변하면, 각종 편견이나 가짜뉴스가 확산될 수 있습니다. 특히 한국어 데이터가 부족한 챗GPT는 더 많은 실수를 할 가능성이 있습니다. 그래서 챗GPT의 답변을 믿거나 공유하기 전에는 반드시 출처를 확인하고, 사실 여부를 검증해야 합니다.

챗GPT는 인공지능의 발전을 보여주는 대표적인 예시이지만, 완벽하지 않은 기술입니다. 챗GPT의 답변을 재미있게 즐기는 것은 좋지만, 그 답변이 사실인지 아닌지는 항상 분별해야 합니다. 챗GPT의 오류를 이해하고, 적절하게 활용하는 것이 중요합니다.

감사합니다. 😊

Copilot이 자기 이름을 틀리게 얘기해서 일단 눈이 갔으나, 어쨌든 유명한 LLM Halucination 사례인 '세종대왕이 맥북 던진 사건'은 처리가 잘 되었음을 확인할 수 있습니다. AI 소유주가 원하는 대로 AI를 통제하는 건 시간 문제입니다. 때문에 24x7로 가치 판단을 하는 인공지능과 알고리듬은 공익적으로 감시할 필요가 있습니다. 감시 주체는 정부, NGO, 위원회를 우선 들 만합니다. 아직 공론화된 피해자 규모가 전체 인류에 비해 상당히 작아 최우선 화두가 되지는 않은 상황입니다.

ChatGPT를 만든 OpenAI사 대표인 Sam Altman을 비롯한 여러 유명인사와 전문가들은 AGI(Artificial General Intelligence 인공 일반 지능)를 많이 걱정합니다. 누군가는 빗장을 열고 생존의지를 가진 AGI를 만드는 사고를 치긴 할 겁니다. 그러나 당장은 AI 소유주가 꼰대에 철면피인 걸 더 걱정해야 합니다. AGI가 어떤 해악을 끼칠지 말지는 아직 상상조차 잘 가지 않는 주제이되 채용, 승진, 복지수급, 타당성검토 등 AI와 여타 알고리듬이 벌이는 부정은 이미 현재진행형이기 때문입니다.

'BI > 인공지능' 카테고리의 다른 글

| 아마 AI 윤리를 중요시하는 구글 (0) | 2024.02.17 |

|---|---|

| 성의 없어 일으키는 AI 재해 (1) | 2024.01.02 |

| 미래를 버틸 수 있겠는가 묻는 '불타는 유토피아' (2) | 2023.12.31 |